5.6 Testes de regressão

O uso da econometria para a pesquisa empírica é sempre um processo de tentativa e erro. É necessário inicialmente escolher a especificação de uma relação matemática entre várias séries, que podem ter sido selecionadas no banco de dados ou produzidas por transformações lineares ou não-lineares de outras séries (como logaritmo ou taxa de variação percentual).

A relação pode incluir uma estrutura dinâmica, especificando que determinadas variáveis entram com defasagens. Nesta etapa inicial de especificação o pesquisador pode basear-se em princípios teóricos ou na sua experiência pessoal.

Depois de especificada e estimada a regressão, o passo seguinte consiste numa bateria de testes que permitam avaliar a qualidade da especificação escolhida sob diversos aspectos. Segundo Hendry (1980), “as três regras de ouro da econometria são testar, testar e testar”.

A partir do resultado dos diversos testes pode parecer interessante rever a especificação inicial e, neste caso, todo a bateria de testes é repetida mais uma vez. Em algum momento (com um pouco de sorte) encontra-se uma especificação que resista bem a todos os testes e pareça fazer sentido do ponto de vista da teoria e da experiência prévia do pesquisador.

Neste ponto o processo de pesquisa empírica atingiu o seu objetivo: uma representação empírica exata da relação matemática entre determinadas variáveis. Os procedimentos de teste partem da definição de uma “hipótese nula” a ser testada. O resultado do teste é composto pelos valores amostrais de uma ou mais estatísticas de teste e de probabilidades a elas associadas (ou valores-p).

A essência de um teste é estimar a probabilidade, na suposição de que a hipótese nula é verdadeira, de se obter um valor teórico para a estatística utilizada que seja maior ou igual (em valor absoluto) que a estatística amostral observada.

Um valor pequeno para essa probabilidade sugere a rejeição da hipótese nula. Por exemplo, uma probabilidade (ou valor-p) entre 0,05 e 0,01 indica que a hipótese nula pode ser rejeitada ao nível de significância de 5% mas não ao nível de significância de 1%.

Os testes de regressão podem se acessados através do botão Diagnósticos que aparece na parte superior da janela de saída da regressão, e são de três tipos: de coeficientes, de resíduos e de estabilidade.

5.6.1 Testes de coeficientes

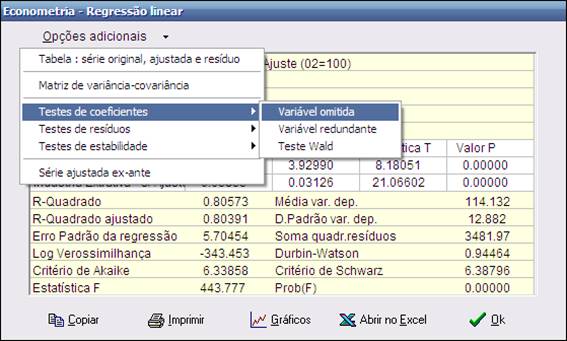

O Macrodados disponibiliza três tipos de testes sobre os coeficientes de uma regressão: teste de variável omitida, teste de variável redundante e teste Wald. Para processar os testes clique no botão Opções adicionais, na parte superior da janela de saída.

5.6.1.1 Variável Omitida

Este teste determina se uma ou mais variáveis omitidas de uma regressão deveriam ter sido incluídas ou não. O critério é examinar se as variáveis omitidas teriam uma contribuição significativa na explicação da variável dependente, ou seja, se são significantes.

Hipótese nula : as variáveis omitidas não são significantes

O programa gera uma regressão auxiliar incluindo as variáveis omitidas e mostra uma saída de regressão que inclui as estatísticas F e Log Razão Verossimilhança. São também mostradas as probabilidades associadas.

ü Um valor pequeno para essas probabilidades sugere a rejeição da hipótese nula. Um valor menor que 0,05 indica que a probabilidade que as variáveis omitidas sejam significantes é de 95%.

Considere o seguinte exemplo de especificação :

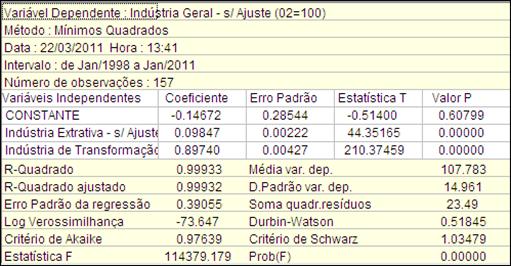

Variável dependente (Y) : Industria Geral s/ ajuste (02=100)

Variáveis independentes :

C : Constante

X1 : Industria Extrativa s/ ajuste (02=100)

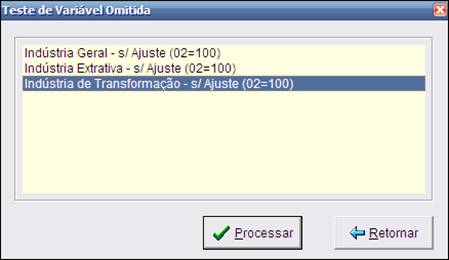

Para ilustrar, vamos testar se outra variável X2 deveria ser ou não incluídas na regressão, onde X2 é a série Industria de Transformação s/ ajuste (02=100).

A hipótese nula do teste é que a variável omitida não é significativa (e que, portanto, não deveria mesmo ter sido incluída). Em outras palavras, a hipótese nula é de que não houve omissão da variável considerada.

Para realizar o teste é necessário que a variável cuja omissão está sendo testada já se encontre na área de trabalho.

É necessário também que essa variável disponha de observações para todo o intervalo de tempo da regressão. Caso contrário será necessário redefinir o intervalo para que o teste possa ser realizado.

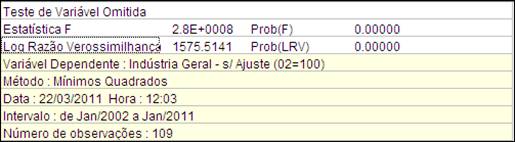

Para realizar o teste, o Macrodados roda uma regressão auxiliar incluindo as variáveis omitidas e mostra uma nova janela de saída. São apresentadas nesta janela as estatísticas F e de razão de verossimilhança com as suas respectivas probabilidades (valores-p).

A estatística F é construída comparando-se as somas dos quadrados dos resíduos da regressão original (So) e da regressão auxiliar (Sa), que inclui a variável omitida:

F = [(So – Sa)/ (Ka -Ko)] / [Sa/ (N-Ka)]

,sendo N o número de observações, Ko o número de parâmetros da regressão original e Ka o número de parâmetros da regressão auxiliar, sempre contando a constante.

Se a hipótese nula for verdadeira e os resíduos teóricos forem independentes e com distribuição normal, a estatística F tem uma distribuição F com (Ka-Ko) graus de liberdade no numerador e (N-Ka) graus de liberdade no denominador.

A estatística Log Razão de Verossimilhança (LRV) compara as log verossimilhanças da regressão original (Lo) e da regressão auxiliar (La):

LRV = -2*(Lo-La)

Se a hipótese nula for verdadeira a estatística LVR converge assimptoticamente para uma distribuição qui-quadrado com (Ka-Ko) graus de liberdade.

No exemplo apresentado o teste rejeita a hipótese nula de que o conjunto das variáveis omitidas têm coeficientes nulos ao nível de significância de 5% e ao nível de significância de 1%.

Em outras palavras, o resultado do teste indica que a variável X2 adiciona uma contribuição significativa à explicação da variável dependente.

5.6.1.2 Variável Redundante

Este teste determina se uma ou mais variáveis da regressão podem ser excluídas sem maiores conseqüências.

Hipótese nula : as variáveis selecionadas são redundantes

A hipótese nula é que os coeficientes das variáveis selecionadas na regressão não são todos estatisticamente diferentes de zero. Se a hipótese for rejeitada as variáveis não são redundantes, isto é, não podem ser excluídas da regressão sem comprometer o nível de explicação da variável dependente.

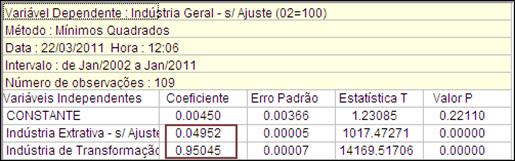

Para exemplificar, vamos considerar a regressão do item anterior mas com a inclusão da variável X2 - Industria de Transformação s/ ajuste (02=100).

O objetivo é testar se X2 é ou não redundante na regressão considerada.

O programa gera uma regressão auxiliar excluindo as variáveis que estão sendo testadas e mostra uma saída de regressão que inclui as estatísticas F e Log Razão Verossimilhança. São também apresentadas as probabilidades a elas associadas.

ü Um valor pequeno para essas probabilidades sugere a rejeição da hipótese nula. Um valor menor que 0,05 indica que a probabilidade que as variáveis selecionadas não sejam redundantes é de 95%.

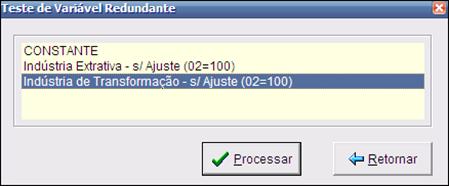

Para realizar o teste clique na opção Variável redundante, como na figura abaixo :

A seguir selecione a variável a testar, como mostrado na figura abaixo :

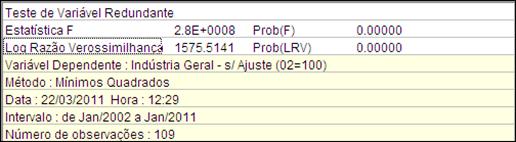

A figura a seguir mostra a janela de saída do teste :

A construção da estatística F e da estatística de razão de verossimilhança é semelhante à utilizada no teste de variável omitida.

Todavia temos aqui uma inversão dos papéis da regressão original e da regressão auxiliar (por exemplo, na estatística F troque So por Sa e Ko por Ka, e vice-versa).

No exemplo apresentado o teste rejeita a hipótese nula de que a variável selecionadas é redundantes mesmo ao nível de significância de 1%. Ou seja, pode-se aceitar a hipótese alternativa de que a variável não é redundante e, portanto, de que deveria estar mesmo incluída na regressão.

Em outras palavras, como a variável X2 adiciona uma contribuição significativa à explicação da variável dependente, sua inclusão é justificada.

5.6.1.3 Wald

O teste Wald é usado para examinar restrições impostas aos coeficientes da regressão (hipótese nula). Ele calcula uma estatística de teste (Wald-Qui quadrado) que mede a eficiência das estimativas dos coeficientes da regressão original em satisfazer as restrições da hipótese nula.

Considere o modelo básico de regressão linear múltipla em notação matricial : Y = X b + e , onde b é um vetor de k parâmetros a serem estimados.

Seja R uma matriz q x k conhecida, onde q é o número de restrições lineares da hipótese nula e seja I um vetor de tamanho q. Então :

Hipótese nula : R b = I

Para uma regressão com k coeficientes estimados, queremos testar a hipótese de que o sistema de equações lineares (restrições) abaixo possa ser aceito a um certo nível de significância.

R11*a1 + R21*a2 + ... + Rk1*ak = I1

R12*a1 + R22*a2 + ... + Rk2*ak = I2

...

R1q*a1 + R2q*a2 + ... + Rkq*ak = Iq

, onde Rij é o i-ésimo parâmetro da j-ésima restrição na matriz

A estatística Wald de teste é calculada pela equação abaixo, em notação matricial :

W = (R b – r)’ (s2 R (X’ X)-1 R)-1 (R b - r)

,onde b é o vetor dos parâmetros estimados sem restrição

Se a hipótese nula for verdadeira, a estatística W tem uma distribuição assimptótica Qui-quadrado com q graus de liberdade.

Na hipótese em que os erros são independentes e normalmente distribuídos, a estatística F é calculada da seguinte maneira :

F = [ ( e’e – u’u ) / q ] / [ (u’u) / (N-k) ] = W/q

, onde e é o vetor de resíduos da regressão com restrições

u é o vetor de resíduos da regressão sem restrições

A estatística F compara a soma dos quadrados dos resíduos da regressão com restrições com a soma dos quadrados dos resíduos da regressão sem restrições. Se as restrições são válidas, deve haver pouca diferença e conseqüentemente o valor da estatística F deve ser baixo.

O programa também calcula as probabilidades Prob(Wald) e Prob(F), usadas para testar a validade da hipótese nula.

Para processar o teste Wald clique em Opções adicionais na janela de saida da regressão e selecione Testes de coeficientes - Wald.

O teste só é válido para regressões com número de independentes maior ou igual a dois. Se o número de variáveis independentes for maior que dois, será solicitado o número de restrições aos coeficientes.

Informe o número de restrições desejado e clique em Ok. Para o caso de duas variáveis independentes, o programa considera uma restrição. Para exemplificar, considere o nosso exemplo básico.

Y = C + a1*X1 + a2*X2 , onde

Y : Industria Geral (2002=100)

C : Constante

X1 : Indústria Extrativa (2002=100)

X2 : Industria de Transformacao (2002=100)

A partir das estimativas obtidas pela regressão, vamos testar se a soma dos coeficientes a1 e a2 á igual a um.

Logo nossa restrição é a1 + a2 = 1.

No teste Wald o programa solicita as restrições em uma matriz onde as linhas correspondem às restrições e as colunas correspondem aos coeficientes. Cada célula corresponde a um parâmetro Rij do nosso sistema de equações. A última coluna (Intercepto) deve conter o valor do lado direito da equação.

No nosso exemplo a matriz deve ser preenchida como na figura a seguir. Neste caso R11 = 1, R21 = 1 e I1 = 1 :

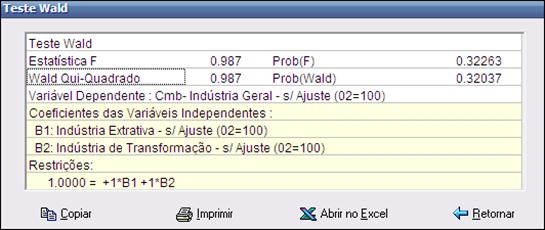

Após o preenchimento das células da matriz, clique em Ok para obter a janela de saida. Neste exemplo obtivemos o seguinte resultado :

Como o exemplo considera apenas uma restrição, as estatísticas F e Wald se igualam. Os valores relativamente pequenos das probabilidades Prob(F) e Prob(Wald) sugerem a rejeição da hipótese nula, ou seja, existe probabilidade em torno de 78% que a soma dos coeficientes não seja igual a um.

5.6.2 Testes de resíduos

O Macrodados disponibiliza cinco tipos de testes sobre os resíduos de uma regressão: normalidade, heteroscedasticidade de White, White excluindo termos cruzados, heteroscedasticidade autoregressiva condicional (ARCH) e correlação serial de Breusch e Godfrey.

5.6.2.1 Normalidade

Em geral os testes existentes para modelos de regressão só são válidos em amostras pequenas quando se assume que os distúrbios aleatórios têm distribuição normal.

É verdade que mesmo sem a hipótese de normalidade, o uso de muitos testes ainda pode ser justificado em amostras grandes com base em resultados assimptóticos, mas há sempre que se ter cuidados com a possibilidade de viés em amostras pequenas.

A normalidade dos resíduos pode ser testada utilizando o recurso de estatísticas descritivas para a série dos resíduos estimados na regressão.

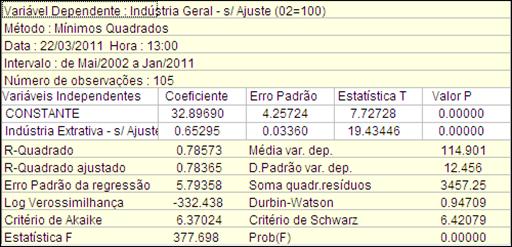

Para exemplificar vamos considerar a regressão do modelo abaixo :

Variável dependente (Y) : Industria Geral s/ ajuste (02=100)

Variáveis independentes :

C : Constante

X1 : Industria Extrativa s/ ajuste (02=100)

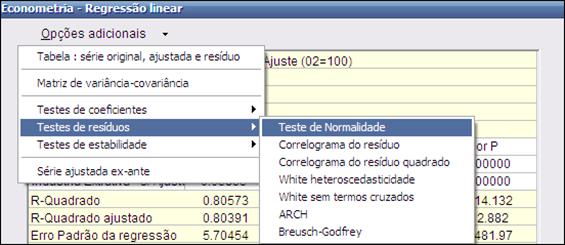

Para usar este teste, proceda conforme indicado na figura a seguir.

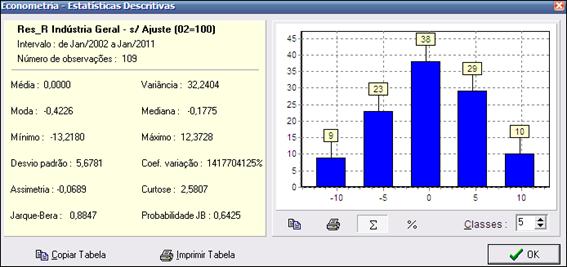

Se os resíduos têm distribuição normal, seu histograma deve ter a conhecida forma de sino e a estatística de Jarque-Bera não deve ser significante.

A estatística Jarque-Bera é baseada nas diferenças entre os coeficientes de assimetria e curtose da distribuição observada da série e da distribuição normal teórica.

Ela serve para testar a hipótese nula de que a amostra foi extraída de uma distribuição normal.

A figura abaixo ilustra a saída do teste de normalidade do resíduo :

Sob a hipótese nula de uma distribuição normal, a estatística Jarque-Bera tem distribuição qui-quadrado com 2 graus de liberdade.

A probabilidade JB apresentada na janela de saída do teste é a probabilidade de que a estatística Jarque-Bera exceda (em valor absoluto) o valor observado se a hipótese nula de normalidade dos resíduos for verdadeira.

ü Uma probabilidade pequena (isto é, um valor de probabilidade JB próxima de zero) significa que a hipótese de normalidade deve ser rejeitada.

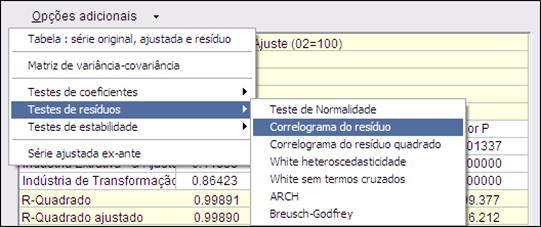

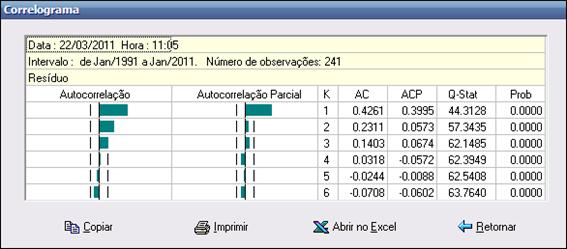

5.6.2.2 Correlograma do resíduo

Esta opção apresenta as autocorrelações e autocorrelações parciais dos resíduos da equação estimada para um número especificado de defasagens.

É mostrada uma janela que solicita o número de defasagens (K) a ser considerado. Informe o número desejado e clique em Ok.

5.6.2.3 Correlograma do resíduo quadrado

Apresenta as autocorrelações e autocorrelações parciais dos resíduos ao quadrado para um número especificado de defasagens.

Estes resultados podem ser usados para verificar heteroscedasticidade condicional autoregressiva (ARCH) nos resíduos (veja item 5.6.2.6). Quando existe ARCH a magnitude dos resíduos aparenta estar relacionada à magnitude de resíduos recentes.

Se não existe ARCH nos resíduos, as autocorrelações e as autocorrelações parciais devem ser zero para todos os lags e a estatística Q não deve ser significante.

Após selecionar esta opção, informe o número de defasagens (K) a considerar, conforme o item anterior, para ver o correlograma.

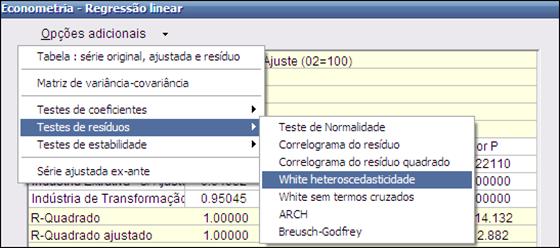

5.6.2.4 White Heteroscedasticidade

Uma das hipóteses do modelo de regressão é a de homocedasticidade, isto é, a de que a variância teórica do termo de distúrbio aleatório, condicional em relação às variáveis independentes, seja constante.

Quando a variância teórica (não observável) do distúrbio aleatório muda ao longo de diferentes segmentos do intervalo de tempo considerado ou em função de variáveis independentes temos o caso de heteroscedasticidade.

Neste caso os estimadores de mínimos quadrados deixam de ser estimadores lineares não-tendenciosos ótimos (BLUE) e perdem sua eficiência assimptótica. Além disso, todos os testes de hipóteses baseados em estatísticas t, F e Qui-quadrado deixam de ser válidos.

Hipótese nula : não há heteroscedasticidade

Para exemplificar vamos considerar a regressão do modelo abaixo :

Variável dependente (Y) : Industria Geral s/ ajuste (02=100)

Variáveis independentes :

C : Constante

X1 : Industria Extrativa s/ ajuste (02=100)

X2 : Industria de Transformação s/ ajuste (02=100)

Para processar este teste, proceda como mostrado na figura a seguir.

O teste foi motivado pela observação por White (1980) de que a hipótese de homocedasticidade pode ser substituída pela hipótese mais fraca de que os quadrados dos resíduos teóricos são não correlacionados com todas as variáveis independentes, seus quadrados e seus produtos cruzados.

Partindo de uma regressão original, como por exemplo:

y = c + a1 X1 + a2 X2 + e

o teste gera uma regressão auxiliar da forma:

e2 = b0 + b1 X 1 + b2 X 2 + b3 X 12 + b4 X 22 + b5 (X 1 X 2)

A regressão auxiliar inclui o quadrados dos resíduos estimados como variável dependente e também adiciona ao conjunto de variáveis independentes da regressão original os seus quadrados e todos os seus produtos cruzados.

Note-se que a regressão auxiliar sempre incorpora uma constante, mesmo quando esta não está presente na regressão original.

Alternativamente podemos entender a regressão auxiliar como resultado da adição ao conjunto de variáveis independentes de uma nova variável igual ao quadrado de sua soma, isto é:

e2 = b0 + b1 X1 + b2 X2 + b3 (X1 + X2)2

Isto auxilia na identificação dos termos com prefixo “Cmb*” que aparecem na saída da regressão auxiliar.

Por exemplo, com três variáveis independentes x1, x2 e x3 na regressão original, as variáveis independentes da regressão auxiliar serão x1, x2 , x3 , (x1)2, (x1 x2) , (x1 x3), (x2)2, (x2 x3) , (x3)2, numa ordem de apresentação similar ao desenvolvimento algébrico de (x1 + x2) 2.

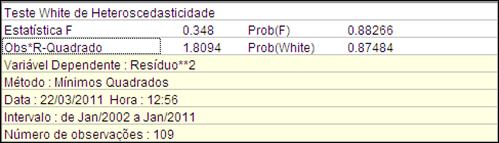

A janela de saída do teste apresenta, além da regressão auxiliar, as estatísticas F e de White com as probabilidades (valores-p) associadas.

ü A estatística F corresponde a um teste de que todas as variáveis independentes da regressão auxiliar, com exceção da constante, são redundantes.

A estatística “Obs*R-Quadrado”, corresponde ao produto do número de observações pelo valor do R-Quadrado da regressão auxiliar.

Se a hipótese nula de que não existe heteroscedasticidade for verdadeira, a distribuição dessa estatística converge assimptoticamente para uma distribuição Qui-quadrado com número de graus de liberdade igual ao número de variáveis independentes da regressão auxiliar, sem contar a constante.

ü No exemplo apresentado a hipótese nula de que não existe heteroscedasticidade pode ser aceita ao nível de significância de 12%.

5.6.2.5 White sem Termos Cruzados

Este teste é uma versão simplificada do teste de White, que exclui da regressão auxiliar todos os termos cruzados do tipo (xi xk). A simplificação é recomendável quando o número de variáveis independentes da regressão original é grande, o que pode reduzir muito severamente o número de graus de liberdade da regressão auxiliar.

Note-se que se o número de variáveis independentes da regressão original for igual a k, sem contar a constante, o número de variáveis independentes da regressão auxiliar será igual a (1,5k+0,5k2) mais a constante, ou seja o número de variáveis independentes da regressão auxiliar cresce em função do quadrado do número de variáveis independentes da regressão original. Por exemplo, com k=5 este número será igual 21; com k=6 já atingirá 28.

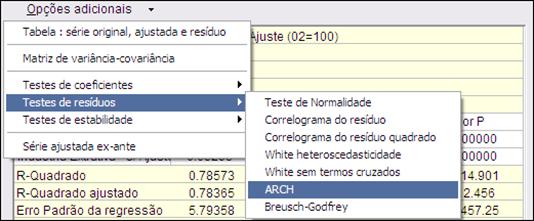

5.6.2.6 ARCH

Este é um teste do tipo ”multiplicador de Lagrange” para a hipótese dos resíduos terem uma estrutura ARCH. ARCH significa heteroscedasticidade condicional autoregressiva, ou seja, a magnitude dos resíduos aparenta estar relacionada à magnitude de resíduos recentes.

A presença de ARCH em si não invalida o método de mínimos quadrados, mas ignorar seus efeitos pode resultar em perda de eficiência na estimação.

Hipótese nula : não há ARCH

Essa especificação foi desenvolvida por Engle(1982) a partir da observação de que em determinadas séries a volatilidade dos resíduos parece ter correlação serial, ou seja, certos períodos parecem caracterizados por seqüências de resíduos grandes enquanto outros períodos parecem caracterizados por seqüências de resíduos pequenos.

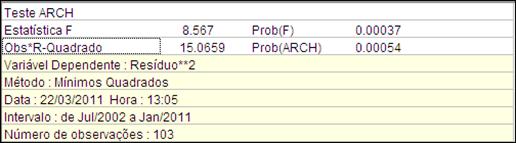

A hipótese nula do teste é a de que não existe ARCH quando se consideram q defasagens nos resíduos (ou alternativamente, de que as variáveis defasadas na regressão auxiliar são redundantes).

Inicialmente, o usuário deve especificar o número de defasagens a ser considerado, conforme a figuraa seguir.

Se foram especificadas q defasagens (com q sempre maior do que zero), o Macrodados rodará uma regressão auxiliar usando os quadrados dos resíduos estimados pela regressão original e suas q defasagens:

(e t)2 = b0 + b1 (e t-1)2 + ... + bq (e t-q)2

Se os resíduos tiverem uma estrutura ARCH, os coeficientes das defasagens nessa regressão serão conjunta e significativamente diferentes de zero.

A janela de saída do teste apresenta uma estatística F e uma estatística do tipo multiplicador de Lagrange, conhecida como estatística LM de Engle, junto com as probabilidades (valores-p) associadas.

ü Se Prob(ARCH) for menor do que um determinado nível de significância, digamos 5%, a conclusão é que podemos rejeitar a hipótese nula.

A estatística F corresponde a um teste de que todas as variáveis independentes da regressão auxiliar, com exceção da constante, são redundantes.

A estatística LM de Engle é da mesma forma “Obs*R-Quadrado” já encontrada no teste de White, correspondendo ao produto do número de observações pelo valor do R-Quadrado da regressão auxiliar.

Se a hipótese nula de que não existe uma estrutura ARCH nos resíduos for verdadeira, a distribuição dessa estatística converge assimptoticamente para uma distribuição Qui-quadrado com número de graus de liberdade igual ao número de variáveis independentes da regressão auxiliar sem contar a constante, ou seja, igual ao número de defasagens utilizadas.

ü No exemplo apresentado a hipótese nula de que as variáveis defasadas na regressão auxiliar são redundantes pode ser aceita, ou seja, não existe uma estrutura ARCH com duas defasagens nos resíduos.

5.6.2.7 Breusch-Godfrey Correlação Serial

O teste de Breusch-Godfrey para correlação serial é outro teste da classe de testes assimptóticos conhecidos como testes de multiplicador de Lagrange (LM).

Ao contrário do teste de correlação serial com base na estatística de Durbin-Watson, que só se aplica a processos auto-regressivos de primeira ordem, denominados AR(1), o teste Breusch-Godfrey pode ser usado para testar processos ARMA de qualquer ordem.

Além disso, neste teste a presença de variáveis dependentes defasadas no lado direito da equação não produz viés como no caso do teste baseado na Durbin-Watson.

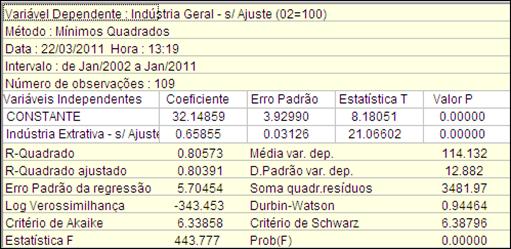

Vamos considerar a regressão original dos itens anteriores :

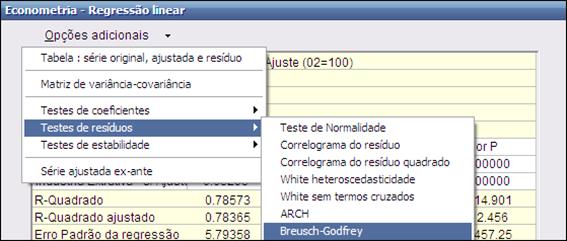

Para acessar o teste, proceda como indicado na figura a seguir.

A hipótese nula do teste é de que não existe correlação serial dos resíduos até a defasagem de ordem q. A hipótese alternativa é que os resíduos são uma ARMA(r,p) sendo q=Max(r,p), ou seja, a hipótese nula é testada contra alternativas tanto AR como MA. Ver Breusch (1978) e Godfrey (1978).

O primeiro passo do teste é a especificação do número de defasagens :

Partindo de uma regressão original, como por exemplo:

y = c + a1 x1 + a2 x 2 + e

que pode conter ou não uma constante, se o usuário especificar um número q de defasagens o Macrodados produzirá uma regressão auxiliar da forma:

e = b0 + b1 x1 + b2 x 2 + b3 et-1 + ... + b(3+q) et-q

, ou seja, uma regressão do resíduo estimado na regressão original contra as variáveis independentes utilizadas, mais uma constante obrigatória e mais as defasagens dos resíduos.

Hipótese nula : não há correlação serial até a ordem q

Seguindo a orientação de Davidson e MacKinnon (1993, pág. 343), os valores dos resíduos defasados que antecedem o intervalo de tempo da regressão original devem ser zerados, de modo que a regressão auxiliar possa ser estimada no mesmo intervalo.

Davidson e MacKinnon demonstram que essa opção produz estatísticas de teste com melhores propriedades em amostras finitas do que a alternativa de reduzir o intervalo de tempo da estimativa.

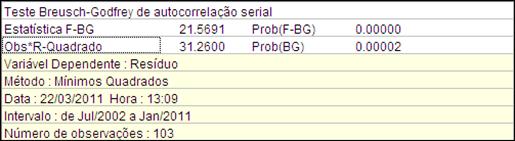

A janela de saída do teste apresenta uma estatística F e uma estatística do tipo multiplicador de Lagrange, conhecida como estatística LM de Breusch-Godfrey, junto com as probabilidades (valores-p) associadas :

A estatística F corresponde a um teste de que todas os resíduos defasados da regressão auxiliar são redundantes.

A estatística LM de Breusch-Godfrey é da mesma forma “Obs*R-Quadrado” encontrada nos testes de heteroscedasticidade de White e no teste de ARCH nos resíduos, correspondendo ao produto do número de observações pelo valor do R-Quadrado da regressão auxiliar.

Se a hipótese nula de que não existe correlação serial dos resíduos até a defasagem de ordem q for verdadeira, a distribuição dessa estatística converge assimptoticamente para uma distribuição Qui-quadrado com q graus de liberdade.

ü No exemplo apresentado a hipótese nula de que não existe correlação serial dos resíduos ou, equivalentemente, que o resíduo defasado incluído na regressão auxiliar é redundante, pode ser rejeitada mesmo ao nível de significância de 1%.

Ou seja, o teste sugere que existe de fato auto-correlação de primeira ordem nos resíduos.

Note-se que isto confirma o resultado do teste baseado na estatística Durbin-Watson, que foi de apenas 0,94709 na regressão original.

5.6.3 Testes de estabilidade

O Macrodados disponibiliza três tipos de teste para avaliar se os parâmetros da regressão são estáveis ao longo do intervalo de estimativa.

5.6.3.1 Teste Chow

Neste teste a estabilidade dos parâmetros é verificada a dividindo-se o intervalo da amostra em duas partes e estimando-se novamente os parâmetros em cada sub-amostra.

O ponto que divide os dois intervalos é chamado de ponto de quebra e cada sub-amostra deve conter mais observações do que o número de coeficientes estimados. Se esta restrição for um problema devido a poucas observações disponíveis, deve ser usado o Teste Chow Projeção.

O teste Chow compara a soma dos quadrados dos resíduos da regressão original com a soma dos quadrados dos resíduos das novas regressões feitas a partir das sub-amostras.

Caso haja uma diferença significativa nas estimativas, pode-se concluir que houve, a partir do ponto de quebra, uma mudança estrutural no relacionamento entre as variáveis do modelo.

Hipótese nula : as estimativas para os coeficientes são estáveis

São apresentadas duas estatísticas no teste Chow : a estatística F e a estatística Log Razão Verossimilhança.

A estatística F, sob a hipótese de estabilidade, tem uma distribuição F se os resíduos forem independentes e normalmente distribuídos e é calculada da seguinte maneira :

F = [ ( e’e – (u1’u1 + u2’u2) ) / k ] / [ (u1’u1 + u2’u2) / (N-2k) ]

e’e é a soma dos quadrados dos resíduos da regressão original

ui’ui é a soma dos quadrados dos resíduos da sub-amostra i

N é o número total de observações

k é o número de parâmetros estimados

A estatística Log Razão Verossimilhança é baseada na comparação entre os máximos com restrição e sem restrição da função log verossimilhança e tem uma distribuição assimptótica Qui-quadrado com k graus de liberdade sob a hipótese de que há estabilidade, ou seja, de que não há mudança estrutural a partir do ponto de quebra.

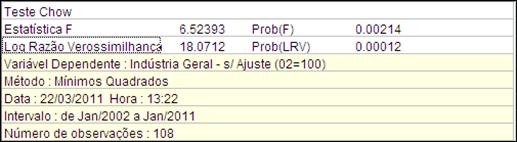

Para exemplificar, considere o exemplo de regressão abaixo, de Jan/02 a Jan/11 :

Variável dependente (Y) : Industria Geral s/ ajuste (02=100)

Variáveis independentes :

C : Constante

X1 : Industria Extrativa s/ ajuste (02=100)

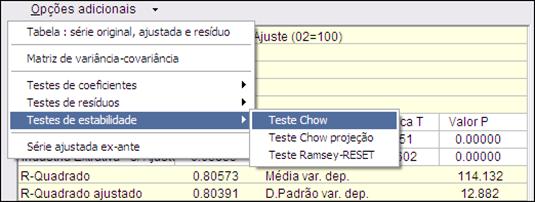

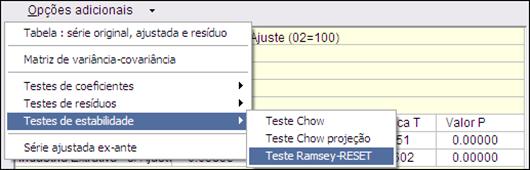

A partir da janela de saída, proceda como na figura a seguir para fazer o teste :

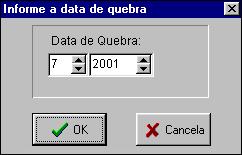

Será então pedida a data do ponto de quebra. Neste exemplo informaremos a data de 11/2008, quando se iniciou a crise global nos mercados financeiros.

Clique em Ok para processar o teste. No caso do exemplo obtém-se a saída da figura a seguir, que nos leva a rejeitar a hipótese nula a partir dos valores Prob(F) e Prob(LRV) calculados:

5.6.3.2 Teste Chow Projeção

O teste Chow Projeção primeiramente estima a regressão para uma sub-amostra que abrange as N1 primeiras observações. Esta estimação é então usada para projetar os valores da variável dependente nas restantes N2 observações.

Caso haja muita diferença entre os valores observados e projetados, a hipótese nula de estabilidade dos coeficientes deve ser rejeitada.

Como no teste Chow simples (veja item 5.6.3.1) , o teste Chow Projeção apresenta duas estatísticas : a estatística F e a estatística Log Razão Verossimilhança.

A estatística F segue uma distribuição F se os erros forem independentes e normalmente distribuídos e é calculada da seguinte maneira :

F = [ ( e’e – u’u) ) / N2 ] / [ (u’u) / (N1-k) ]

e’e é a soma dos quadrados dos resíduos da regressão original

u’u é a soma dos quadrados dos resíduos da sub-amostra N1

N é o número total de observações

Ni é o número total de observações da sub-amostra i

k é o número de parâmetros estimados

Da mesma maneira a estatística Log Razão Verossimilhança é baseada na comparação entre os máximos com restrição e sem restrição da função log verossimilhança e tem uma distribuição assimptótica Qui-quadrado com k graus de liberdade sob a hipótese de que há estabilidade.

Para processar o teste Chow Projeção, a partir da janela de saída, deve-se clicar em Opções adicionais e a seguir em Testes de estabilidade - Chow Projeção.

A seguir deve ser informado o ponto de quebra, ou seja, a data inicial da sub-amostra N2. A análise dos valores Prob(F) e Prob(LRV) levam à aceitação ou rejeição da hipótese nula de estabilidade dos coeficientes.

5.6.3.3 Teste de estabilidade- Ramsey RESET

RESET é um teste proposto por Ramsey (1969). É a abreviatura de “Regression Specification Error Test” (ou, em português, teste de erro de especificação em regressão).

RESET é um teste geral para erros de especificação que podem ter diversas origens, como variáveis independentes omitidas, forma funcional incorreta, erros de medida em variáveis, erros de simultaneidade e inclusão de valores defasados da variável dependente quando os resíduos têm correlação serial.

Para usar esta opção proceda como mostrado na figura a seguir :

A motivação para o teste RESET é muito simples : se a regressão original, por exemplo :

y = c + a1 x1 + a2 x 2 + e

está corretamente especificada e satisfaz a hipótese de que o erro teórico tem valor esperado condicional aos valores das variáveis independentes igual a zero, ou seja:

E(e / x1 , x 2 ) = 0

então a adição de qualquer função não-linear das variáveis independentes à regressão original deve ser irrelevante do ponto de vista da explicação da variável dependente.

A proposta de Ramsey, para evitar o problema de se ter de escolher uma função não-linear específica envolvendo todas as variáveis independentes entre as muitas possibilidades plausíveis, é testar a adição de potências dos valores previstos para a variável dependente na regressão original.

A idéia é que um polinômio construído a partir desses valores estimados da variável dependente pode ser visto como uma “forma reduzida” para diversas combinações diferentes de potências e produtos cruzados envolvendo as variáveis independentes.

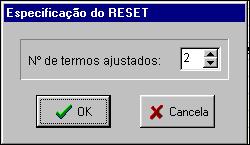

O passo inicial do teste é a especificação do número de potências da série estimada da variável dependente que será incluída. A experiência tem demonstrado que a inclusão de apenas dois termos, ou seja, o quadrado e o cubo da variável dependente estimada tem sido suficiente na maioria dos casos.

A partir da definição do número de termos a serem incluídos, o Macrodados roda a seguinte regressão auxiliar:

y = b0 + b1 x1 + b2 x 2 + b3 (ye)2 + b4 (ye)3

onde ye é a série dos valores estimados da variável dependente na regressão original.

Hipótese nula : a regressão original foi corretamente especificada

ou seja, os coeficientes das potências da variável dependente estimada que foram adicionadas na regressão auxiliar não são significantes.

Se a hipótese for rejeitada, essas potências não podem ser excluídas da regressão sem comprometer o nível de explicação da variável dependente, o que sugere que a regressão original não foi corretamente especificada.

Para exemplificar, considere o nosso exemplo básico :

Variável dependente (Y) : Industria Geral s/ ajuste (02=100)

Variáveis independentes :

C : Constante

X1 : Industria Extrativa s/ ajuste (02=100)

X2 : Industria de Transformação s/ ajuste (02=100)

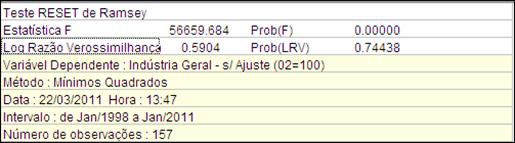

A janela de saída deste teste é similar a do teste de variável omitida, incluindo, além da regressão auxiliar, as estatísticas F e de razão de verossimilhança com as probabilidades (valores-p) associadas.

ü No exemplo apresentado a hipótese nula é aceita, como mostra a figura abaixo, sugerindo que a regressão está corretamente especificada.